test

test

Design et Culture Numérique

Deux mille vingt trois

Université de Nimes

███████╗██████╗ ██╗████████╗ ██████╗

██╔════╝██╔══██╗██║╚══██╔══╝██╔═══██╗

█████╗ ██║ ██║██║ ██║ ██║ ██║

██╔══╝ ██║ ██║██║ ██║ ██║ ██║

███████╗██████╔╝██║ ██║ ╚██████╔╝

╚══════╝╚═════╝ ╚═╝ ╚═╝ ╚═════╝

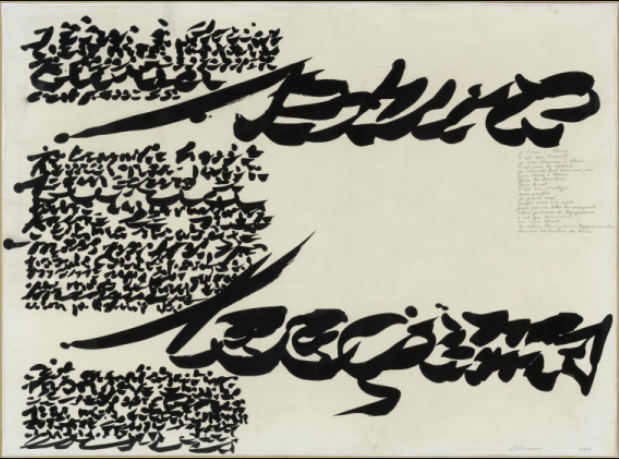

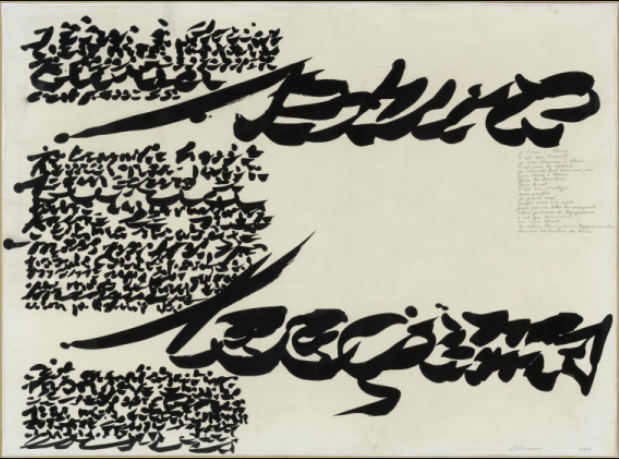

Pour son projet thématique de l'année 2023-2024, l'option Design et Cultures numériques de la Licence Design de l'Université de Nîmes réalise un objet éditorial en web-to-print. Les textes réunis sont sélectionnés en fonction du cadre pédagogique et des thématiques de travail des étudiant·es qui en rédigent la présentation. Cet ouvrage est le premier livre imprimé édité et composé avec l'outil collaboratif BOOKOLAB.

Ces textes donnent lieu à une expérimentation à visée pédagogique dont l'objet est de permettre aux étudiant·es de mieux appréhender les métiers associés aux domaines de la conception éditoriale, graphique, de l'impression numérique, et du façonnage. Portant un intérêt particulier à l'enjeu actuel de la multiplicité des conditions d'accès à un même contenu et à la diversité des supports de lecture, ce projet constitue également une initiation aux techniques de conception graphique et éditoriale multisupport. La composition graphique de ce recueil a été entièrement réalisée avec les outils et technologies du web (html, css). Une version web existe également.

La conception de la mise en page d'un ouvrage avec les technologies du web permet une découverte de la programmation au service d'une pratique graphique. Cette initiation est assurée par un membre du collectif de designers graphiques Bonjour Monde. Ces dernières années, un intérêt pour la programmation, le hack et les valeurs du logiciel libre a émergé chez certain·es designers graphiques. L'utilisation de techniques et outils libres pousse à faire un pas côté dans l'écosystème de création, quitte à assumer une certaine maladresse mais non sans contrepartie.

Inscrivant leur métier dans la tradition de garant de l'accessibilité à l'information, ces designers rejoignent des valeurs issues de la culture des logiciels libres. Le code ouvert, la possibilité de le modifier et de se l'approprier sont considérées comme une condition inaliénable d'accessibilité. Le code devient matière de création au même titre que la typographie et le texte.

Outre l'enjeu de création du design graphique libre qui, adoptant des méthodes encore peu usitées, conçoit des objets graphiques singuliers, cette initiation aux langages standards du web est aussi l'occasion d’expérimenter un processus de création dit en single source publishing qui permet de faire d'une page web un livre et qui constitue un enjeu majeur face aux mutations des pratiques de lecture. Considérant l'imprimé comme un support parmi d'autres, tels que l'écran d'ordinateur ou le petit écran mobile, la conception éditoriale en single source publishing vise à décliner la mise en forme d'un même contenu sémantique (au format html) au moyen de feuilles de style spécifiques, adaptées aux différents supports de lecture. En modifiant leur chaine de travail, les designers sont en mesure de garantir l'accessibilité d'un contenu (texte, information) tout en maitrisant la pérennité et l'interopérabilité des technologies mobilisées pour sa diffusion.

Les objectifs pédagogiques adressent plusieurs aspects du design.

Le recueil est produit en plusieurs exemplaires à destination strictement non commerciale, destinés aux étudiant·es, à la bibliothèque et aux archives de la filière design de l'université de Nîmes, aux responsables pédagogiques de l'établissement et aux enseignant·es de l'option. Ils peuvent en outre être présentés dans des manifestations visant à valo-riser l'offre pédagogique de l'université de Nîmes (tel que des salons étudiants, journées portes ouvertes).

Lucile Haute █▓▒▓█▀██▀█▄░░▄█▀██▀█▓▒▓█ █▓▒░▀▄▄▄▄▄█░░█▄▄▄▄▄▀░▒▓█ █▓▓▒░░░░░▒▓░░▓▒░░░░░▒▓▓█ & Benjamin Dumond █▓▒▓█▀██▀█▄░░▄█▀██▀█▓▒▓█ █▓▒░▀▄▄▄▄▄█░░█▄▄▄▄▄▀░▒▓█ █▓▓▒░░░░░▒▓░░▓▒░░░░░▒▓▓█

Toute l’information imaginable semble accessible en quelques clics et nos ap-pareils nous sollicitent sans cesse pour orienter nos choix dans cet univers infini. Ce fai-sant, le numérique change

la manière dont nous sommes attentifs à ce qui nous occupe et à ce qui nous entoure. Nous avons interrogé Yves Citton sur la portée de ce change-ment et sur le rôle propre

qu’y jouent les nouveaux médias. Ils s’y révèlent ambivalents, et laissent

dès lors prise au politique

et à l’engagement.

Interview de Yves Citton par Thomas Lemaigre dans La Revue Nouvelle 2016/8 (N° 8)

Toute l’information imaginable semble accessible en quelques clics et nos ap-pareils nous sollicitent sans cesse pour orienter nos choix dans cet univers infini. Ce fai-sant, le numérique change

la manière dont nous sommes attentifs à ce qui nous occupe et à ce qui nous entoure. Nous avons interrogé Yves Citton sur la portée de ce change-ment et sur le rôle propre

qu’y jouent les nouveaux médias. Ils s’y révèlent ambivalents, et laissent

dès lors prise au politique

et à l’engagement.

La Revue Nouvelle : Quel est

le cheminement intellectuel parcouru pour arriver à cette notion d’écologie de l’attention, au cœur de vos travaux des dernières années ?

Yves Citton : Je viens de la littérature et d’une réflexion de théorie littéraire sur

ce qu’est lire et en quoi les livres ne sont vivants que dans la mesure où des lec-teurs ou des collectivités

y investissent de l’intérêt,

de l’attention et du temps.

Un livre existe parce que quelqu’un l’interprète et en fait quelque chose. Se crée alors une dynamique entre

lui et le médium, qui est mort

en tant que tel, mais qui a pu anticiper notre attention.

Vous pourriez vous dire que c’est de la communication, mais si vous regardez tout cela du point de vue de la lit-térature, vous vous apercevez qu’il se passe plein d’autres choses — surtout si quelqu’un écrit en 1720 et qu’on le lit

en 2016. Il y a une puissance d’agir propre au médium

et cela vaut pour tous les médias, au sens très large, pas seulement les médias

de masse. C’est cette puis-sance qui m’intéresse.

Les médias sont dépendants de l’attention humaine et l’on pourrait se dire que nous tous, en tant que spectateurs, nous avons un pouvoir énor-meen fait souvent un emblème

de passivité, regarder un film

ou une série TV est bien une

forme d’activité. Politique-regarder un film ou une série TV est bien une forme d’activité. d’hui, la façon dont nous

voyons le monde (et non la façon dont nous voyons le monde (et non seulement les écrans) prend des formes et des contenus qui lui viennent de ce qui est filtré par les médias.forme d’arbres, à tel animal plutôt qu’à tel autre, à telle couleur plutôt qu’à telle

autre.

C’est vraiment l’interface entre médias et attention qui m’intéresse : les médias sont des appareils qui transportent des enregistrements, des filt-rages de données sensibles

Les médias sont dépendants de l’attention humaine et l’on pourrait se dire que nous tous, en tant que spectateurs, nous avons un pouvoir énor-me parce que nous regardons la télévision. Même si l’on

en fait souvent un emblème de passivité, regarder un film ou une série TV est bien une forme d’activité. Politique-ment, cette idée me semblait intéressante. Par ailleurs,

il faut reconnaître que dans l’autre sens, de facto aujour-d’hui, la façon dont nous voyons le monde (et non seulement les écrans) prend des formes et des contenus qui lui viennent de ce qui est filtré par les médias. Même lorsque je regarde une forêt, j’ai en tête des images de re-portage à la Walt Disney qui m’ont rendu sensible à telle forme d’arbres, à tel animal plutôt qu’à tel autre, à telle couleur plutôt qu’à telle

autre.

C’est vraiment l’interface entre médias et attention qui m’intéresse : les médias sont des appareils qui transportent des enregistrements, des filt-rages de données sensibles

et intellectuelles, et ces appa-reils sont investis par une attention qui va elle-même filtrer, choisir, sélectionner

ce qui vient du médium.

Ce sont des rapports très complexes parce que le mé-dium même impose certaines choses et, en même temps, dans ce qui est imposé,

le spectateur a toujours une certaine marge d’activité.

C’est une approche que

le chercheur Stanley Fish

a poussée jusqu’au bout

en disant que le texte ne nous impose aucune signification,le texte ne nous impose aucune signification, que ce sont toujours les

« communautés interprétatives » qui construisent tel ou tel sens dans le texte.la loi ou les textes sacrés :

la loi n’est que ce qu’en fait

le juge, qui doit toujours l’in-terpréter. Il s’agit donc d’un regard à la fois très subversif et très émancipateur, parce que cela veut dire que c’est nous en tant qu’interprètes qui tenons le marteau par

le manche.

et intellectuelles, et ces appa-reils sont investis par une attention qui va elle-même filtrer, choisir, sélectionner

ce qui vient du médium.

Ce sont des rapports très complexes parce que le mé-dium même impose certaines choses et, en même temps, dans ce qui est imposé,

le spectateur a toujours une certaine marge d’activité.

C’est une approche que

le chercheur Stanley Fish

a poussée jusqu’au bout

en disant que le texte ne nous impose aucune signification, que ce sont toujours les « communautés interpréta-tives » qui construisent tel

ou tel sens dans le texte.

Il parlait d’abord en tant que critique littéraire, mais en fait cela se comprend aussi pour le numérique, et même pour la loi ou les textes sacrés :

la loi n’est que ce qu’en fait

le juge, qui doit toujours l’in-terpréter. Il s’agit donc d’un regard à la fois très subversif et très émancipateur, parce que cela veut dire que c’est nous en tant qu’interprètes qui tenons le marteau par

le manche.

RN : Comment cette interaction entre le médium et son utilisateur mute-t-elle avec les technologies de l’information ?

YC : J’aime bien l’idée de mutation.

mutation

mutation

mutation

mutation

mutation

mutation

mutation

mutation

mutation

mutation

mutation

mutation

mutation

mutation

mutation

mutation

mutation

mutation

mutation

mutation

mutation

mutation

mutation

mutation

mutation

mutation

mutation

mutation

mutation

mutation

mutation

mutation

mutation

mutation

Que veut dire mutation ? Que l’on ne part pas de rien, il ne s’agit pas de création ex nihilo. Il y avait quelque chose, mais cette chose, qui est là depuis longtemps, change suffisam-ment de caractéristiques pour avoir l’air de changer de na-ture. Il y a toujours eu, j’imagine, un sentiment de la part des humains que la vie est courte, que l’on aimerait faire plein de choses et que l’on n’en a pas le temps. On trouve

à toutes les époques de l’histoire des gens qui s’inquiètent

de ce déferlement de savoirs, de textes, etc. Comment peut-on s’y retrouver ?

La logique à l’œuvre a été très bien décrite par le chercheur et critique d’art Jonathan Crary à propos de la période 1860-1890. Il montre qu’il s’y passe toute une série de choses sur l’attention. D’une part, le travail en usine force les contre-maîtres et les patrons à contraindre l’attention et la concen-tration des ouvriers. Puis, il faut vendre cette production,

et donc capter l’attention flottante des consommateurs par

la réclame. C’est aussi le moment où se mettent en place, surtout en Allemagne, des mesures très précises des capaci-tés physiques du système nerveux humain : à partir de quelle vitesse on voit passer un objet, à partir de quelle fréquence on entend un son, etc. On prend le système sen-soriel humain comme une sorte de machine qui détecte,

ou non, certains phénomènes et l’on mesure cela précisé-ment. Enfin, toujours à cette époque, se développent plein

de nouveaux médias comme le télégraphe, le téléphone,

le cinéma, puis la radio, la télévision, ainsi que d’autres qui ont rapidement disparu. mutation mutation mutation mutation mutation mutation mutation mutation mutation mutation mutation mutation mutation mutation mutation mutation mutation mutation mutation mutation mutation mutation mutation mutation mutation mutation mutation mutation mutation mutation mutation mutation mutation

Ce sont là de nouvelles machines pour distraire,

au sens étymologique : je suisje suis ici, mais mon attention est tirée loin d'ici.niques va exploser à travers tout le XXe siècle pour nous rendre attentifs à des choses qui sont dans d’autres es-paces-temps, aux JO de Rio en ce moment même, ou dans un vieux film d’Orson Welles. Cela existait déjà avant : lire un roman était déjà « se dis-traire », aller dans un autre espace-temps, mais l’industri-alisation, la publicité, les nou-veaux médias, et la capacité

à mesurer très précisément les capacités du système nerveux humain, cela amène une nouvelle dynamique, déjà une mutation.

Ce sont là de nouvelles machines pour distraire,

au sens étymologique : je suis ici, mais mon attention est ti-rée loin d'ici. Cette « distrac-tion » par des moyens tech-niques va exploser à travers tout le XXe siècle pour nous rendre attentifs à des choses qui sont dans d’autres es-paces-temps, aux JO de Rio en ce moment même, ou dans un vieux film d’Orson Welles. Cela existait déjà avant : lire un roman était déjà « se dis-traire », aller dans un autre espace-temps, mais l’industri-alisation, la publicité, les nou-veaux médias, et la capacité

à mesurer très précisément les capacités du système nerveux humain, cela amène une nouvelle dynamique, déjà une mutation.

Nous vivons une autre mutation, disons à partir des années 1970 où apparaît cette notion de surcharge informationnelle. Des chercheurs et des artistes prennent vraiment conscience de cela, comme Richard Serra et sa vidéo Television delivers people en 1973. Vingt ans plus tard, internet se déploie comme une sorte de médiathèque infinie… Le sentiment d’épuisement de l’attention devient de plus en plus intense.

Il convient à ce propos de distinguer deux logiques : il y a la surcharge informationnelle par opportunité et la surcharge par sollicitation. Je regarde cette vidéo sur Youtube alors qu’il y en a des millions d’autres dont je sais que beaucoup seront sans doute mieux que celle-ci. Donc je vais en regar-der trente secondes, puis je vais zapper… C’est la surcharge par opportunité, une première mutation qui fait que cela s’accélère, que nous sommes de plus en plus impatients face à la pression qualitative. Si j’ai accès à trois films, ce ne sera pas difficile de choisir celui qui me plaît le plus, si j’en ai deux millions, ce sera plus compliqué. Mais cet embarras

du choix, pour moi, ce n’est pas le plus important.

L’autre surcharge, ce sont les sollicitations : ce n’est pas uni-quement moi qui peux aller prendre ces contenus, beaucoup sont poussés vers moi, et je suis même sommé de répondre. Le philosophe italien Maurizio Ferraris parle de « mobilisa-tion totale ». Nous sommes vraiment assiégés par nos appa-reils connectés. Les barrières se brouillent entre les diffé-rentes sphères de l’existence du fait qu’il y a trop de sollici-tations pour que, avec les quelques heures de veille dont

on dispose chaque jour, l’on puisse répondre à toutes.

La mutation, c’est le fait qu’il ne s’agit plus seulement pour moi, à un moment donné, d’avoir le meilleur film, mais

de répondre ou non au médium qui m’en informe, avec éventuellement des conséquences pas du tout anodines, comme de me faire virer de mon travail, d’être impoli,

ou encore de sous-cultiver ma notoriété et, de ce fait, renoncer à un revenu futur. Surcharge par opportunité

et par sollicitation jouent en un continuum très étendu

de formes de pouvoir sur mon attention. On peut donc parler de mutation au sens de phénomènes quantitatifs qui ont des transformations qualitatives, parce qu’au bout d’un moment de ce jeu, certains peuvent se retrouver tellement épuisés qu’ils tombent en dépression ou en « burn-out numérique ».

RN : N’y a-t-il pas là un para-doxe de la part de ces opéra-teurs culturels ou médiatiques dominants, qui poussent l’accélération de ces notifi-cations, donc qui tendent

à susciter cet épuisement,

alors que le médium nécessite

un utilisateur subjectivement impliqué et actif ?

YC : Cette mutation

de l’activité du lecteur, c’est en quelque sorte le passage du livre ou du web 1.0

à l’internet d’aujourd’hui, dans lequel on a introduit l’interactivité. Non seule-ment vous accédez à ce qui est posté, mais vous pouvez y répondre, vous pouvez vous-même poster vos propres contenus, etc. Mais le numérique comme tel n’est pas seul en cause. Cela devient intéressant quand,

à l’intérieur du numérique, on arrive à classifier un peu les choses. Si l’unidirection-nalité des mass médias

se renverse et que chacun devient le média de l’autre en produisant de la matière qui va nourrir l’intelligence collective, c’est plutôt positif, c’est une sorte de démocrati-sation merveilleuse. C’est central dans le numérique,

et il faut le cultiver.

En même temps, on en voit plutôt la face sombre, à sa-voir que nous devons parti-ciper et nous exprimer,

et donc chaque fois que l’on regarde quelque chose

se produit une sorte d’injonction, il faut que

tu répondes et que

tu montres que tu existes.

Le paradoxe, c’est justement l’ambivalence que porte chaque évolution : il y a des tendances qui sont tout

à fait dangereuses et d’autres qui sont merveilleuses.

Intervient ici la notion de subjectivité computation-nelle. Se construire soi-même comme sujet, cela

se fait à travers des condi-tionnements, des conditions de communication, de pen-sée, de survie, et c’est

à l’intérieur de nos échanges avec nos semblables et dans notre environnement que nous construisons chacun notre singularité.

Il s’agit désormais de reconnaître que les médias numériques jouent un rôle de plus en plus important, au point de restructurer nos subjectivations. Il s’agit de comprendre en quoi être sujet en 2016 et en 1970, c’est quelque chose de différent, parce qu’un téléphone portable connecté est différent d’un téléphone par ligne fixe.moins cher, etc. Et en même temps — et la distinction

va être là —, on va produire des traces instantanées. Il y a là quelque chose d’absolu-ment nouveau pour l’histoire de l’humanité : tout ce que l’on fait avec le numérique laisse des traces, dont plein d’acteurs ont intérêt à s’em-parer, même sans avoir accès au contenu même, à ce qui s’est dit au téléphone dans notre exemple. Il est clair que quand vous envoyez un cour-riel avec Gmail, il y a un enre-gistrement automatique extérieur aux deux communi-cants. Il y a toujours un tiers.

Il s’agit désormais

de reconnaître que les médias numériques jouent un rôle

de plus en plus important,

au point de restructurer nos subjectivations. Il s’agit

de comprendre en quoi être sujet en 2016 et en 1970, c’est quelque chose de différent, parce qu’un téléphone por-table connecté est différent d’un téléphone par ligne fixe. Il y a des choses que l’on peut toujours faire ensemble, comme parler avec un parent lointain, et le progrès tech-nique rend cela plus facile, moins cher, etc. Et en même temps — et la distinction

va être là —, on va produire des traces instantanées. Il y a là quelque chose d’absolu-ment nouveau pour l’histoire de l’humanité : tout ce que l’on fait avec le numérique laisse des traces, dont plein d’acteurs ont intérêt à s’em-parer, même sans avoir accès au contenu même, à ce qui s’est dit au téléphone dans notre exemple. Il est clair que quand vous envoyez un cour-riel avec Gmail, il y a un enre-gistrement automatique extérieur aux deux communi-cants. Il y a toujours un tiers.

C’est quelque chose que notre vocabulaire n’a pas encore intégré : la « donnée » est une forme de prise. Les données ne sont jamais données, elles se trouvent être des données parce que quelqu’un a jugé bon de les prendre. Dès lors,

si chaque fois que l’on avait un énoncé avec le mot « don-née », on le remplaçait par « prise », cela donnerait des effets politiques tout à fait intéressants. On retrouve

là l’ambivalence déjà évoquée : les données, c’est le don, c’est le gratuit, c’est merveilleux de donner sans compter, etc., mais rappelons-nous que si les données ont été prises, elles ont été prises pour des raisons précises, qui appartiennent en général soit à des forces de police, soit à des forces commerciales du marché capitaliste.

RN : Après Snowden,

on ne peut plus réfléchir à ces questions de la même manière, même si internet n’est plus concevable sans ces « prises » de données. Mais voyez-vous aussi à l’œuvre d’autres logiques des big data que celles du contrôle sécuritaire et des superprofits financiers ?

YC : Il y a de plus en plus

de prises qui sont artis-tiques, tout un art qui

se développe sur les métadonnées, sur ce jeu entre données et prises. J’ai beaucoup d’admiration

et de grands espoirs que par des moyens artistiques nous puissions à la fois mieux comprendre ce qui se passe et ce que l’on pourrait faire. On constate quand même

un déficit assez catastro-phique en la matière de la part des politiques, alors que justement du côté écono-mique, Gafam1 et autres sont bien en avance vu les attentes de profit que nourrissent ces formes d’économie.

Un enjeu est notamment

de situer le rôle de chacun, du quidam. C’est justement en tant que n’importe qui que mes données valent quelque chose parce que n’importe qui, on peut

le transformer en statis-tiques, et qu’en même temps c’est ma singularité que l’on vise et que l’on calcule. Pour les big data, nous sommes tous des quidams singula-risés. Et l’on retrouve toujours la même ambi-valence : chacun fait partie

à la fois de ce qui est exploité et de ce qui exploite, chacun est soumis aux médias

et chacun a une certaine marge de pouvoir sur eux. Notre subjectivité computa-tionnelle est clivée. Il s’agit de ne pas trop s’exploiter les uns les autres et finalement de ne pas trop s’exploiter soi-même…

RN : Vous distinguez plusieurs types d’attention, notamment l’attention collective, c’est-à-dire le fait que nous baignons tous dans un certain nombre de discours et de formats portés par nos médias, et qui cadrent les jeux de notre attention individuelle

et de notre attention conjointe (en groupe). Vous parlez même d’« envoûtement médiatique », pour traduire comment cette attention collective surplombe chacun et nous imprègne. Mais

ce contenu, dans l’air du temps, n’est-il pas lui aussi clivé, variable en fonction d’où chacun se situe dans la société ? Il suffit de vivre avec des adolescents pour se rendre compte que tout le monde

ne vit pas dans la même économie de l’attention. Ne conviendrait-il pas de parler d’« économies des attentions » ?

YC : Sans doute. Mais il n’est pas complètement idiot

de parler de l’attention au singulier. Le penseur allemand Georg Franck a écrit l’un des premiers ouvrages qui s’intitulait L’économie de l’attention en 1998. Il y part certes

du constat qu’il n’y a que des attentions dont les objets, les régimes, les qualités, les intensités, etc., sont tellement différents que l’on ne peut pas les comparer : être attentif

à un film, être attentif à la route quand vous conduisez, être attentif quand vous lisez un roman, être attentif à un ami malade, tout cela est trop irréductible, il y a à priori une multiplicité d’attentions hétérogènes, hétéroclites, etc. Mais si Franck parle d’économie de l’attention au singulier, c’est qu’il est en train de se passer quelque chose de nouveau parce qu’émerge une mesure homogénéisatrice de l’atten-tion. Le meilleur exemple d’une telle mesure, c’est Pagerank de Google, l’algorithme qui édite les pages de résultats

de vos recherches, qui décide quels items s’affichent, dans quel ordre et aussi comment cela va se monnayer. Si vous êtes Brad Pitt beaucoup de gens parlent de vous, vous pouvez faire de la pub et vous êtes payé des millions

à l’heure. Si vous n’êtes pas Brad Pitt vous ne serez pas payé, etc. Si vous recherchez « tomate » ou votre nom

de quidam, vous générerez des flux d’argent tout à fait différents. C’est quelque chose comme une mesure mondialisée, qui homogénéise toutes les différences

et qui lie une certaine valeur à notre attention.

RN : Nous avons l’habitude d’opposer attention et distraction. Vous vous méfiez de cette vision de l’attention. Pourquoi ?

YC : Il me semble que c’est une vision qui nous emmène dans des discours néoréac-tionnaires parce qu’elle contient un manichéisme simplificateur : « C’est bien d’être attentif ou concentré sur quelque chose et c’est mal d’être distrait ». J’y vois une trace de ce que pointe Jonathan Crary à propos

de l’industrialisation au XIXe siècle : c’est vraiment une position de patron et de contremaître, « je veux que dans mon usine les gens soient attentifs, parce que j’ai des ennuis s’ils commencent

RN : Nous avons l’habitude d’opposer attention et distraction. Vous vous méfiez de cette vision de l’attention. Pourquoi ?

YC : Il me semble que c’est une vision qui nous emmène dans des discours néoréac-tionnaires parce qu’elle contient un manichéisme simplificateur : « C’est bien d’être attentif ou concentré sur quelque chose et c’est mal d’être distrait ». J’y vois une trace de ce que pointe Jonathan Crary à propos

de l’industrialisation au XIXe siècle : c’est vraiment une position de patron et de contremaître, « je veux que dans mon usine les gens soient attentifs, parce que j’ai des ennuis s’ils commencent

La concentration n’est ni un bien ni un mal en soi, c’est juste un mode d’attention parmi d’autres, avec ses forces et ses limites. Je préfère parler de différentes qualités et situ-ations attentionnelles.

La question n’est plus d’être attentif contre distrait, dans

le bien contre le mal, mais

de savoir quelles bonnes attentions développer dans

La concentration n’est ni un bien ni un mal en soi, c’est juste un mode d’attention parmi d’autres, avec ses forces et ses limites. Je préfère parler de différentes qualités et situ-ations attentionnelles.

La question n’est plus d’être attentif contre distrait, dans

le bien contre le mal, mais

de savoir quelles bonnes attentions développer dans

telle circonstance. Et il se peut que cela ressemble à de la dis-traction. Il y a un véritable nuancier des attentions que chacun agence en fonction des circonstances. Les neuro-scientifiques comme Jean-Philippe Lachaux montrent que pour un système nerveuxpour un système nerveux humain, y compris l’appareil sensoriel, c’est un régime tout à fait exceptionnel d’être concentré sur une seule chose à la fois.ce qui est de l’ordre du fond

et ce qui est de l’ordre de la figure qui en émerge.

Il ne faut pas réduire l’atten-tion à une question de sail-lance : quelque chose qui s’impose à notre attention, comme une sirène de pom-piers, une lumière qui clignote, etc., en rapport avec un impératif de survie. Le tra-vail de l’attention, c’est juste-ment, hors situation évidente de saillance, d’ex-traire d’un fond quelque chose qui va être une figure. On en revient directement au numérique, aux écrans et à la surcharge informationnelle par solli-citation. Tel message, fond et forme, qui nous sollicite à travers les écrans, a-t-il

telle circonstance. Et il se peut que cela ressemble à de la dis-traction. Il y a un véritable nuancier des attentions que chacun agence en fonction des circonstances. Les neuro-scientifiques comme Jean-Philippe Lachaux montrent que pour un système nerveux humain, y compris l’appareil sensoriel, c’est un régime tout à fait exceptionnel d’être concentré sur une seule chose à la fois.La fonction première est d’être sensible à plein

de choses en même temps

et de constamment décider

ce qui est de l’ordre du fond

et ce qui est de l’ordre de la figure qui en émerge.

Il ne faut pas réduire l’atten-tion à une question de sail-lance : quelque chose qui s’impose à notre attention, comme une sirène de pom-piers, une lumière qui clignote, etc., en rapport avec un impératif de survie. Le tra-vail de l’attention, c’est juste-ment, hors situation évidente de saillance, d’ex-traire d’un fond quelque chose qui va être une figure. On en revient directement au numérique, aux écrans et à la surcharge informationnelle par solli-citation. Tel message, fond et forme, qui nous sollicite à travers les écrans, a-t-il

été voulu comme une sail-lance ou comme un support au travail actif de l’attention créatrice ? Ce n’est pas l’écran comme tel qui fait problème, c’est ce qui y est proposé comme écologie de l’attention, comme situations et comme qualités attentionnelles.

été voulu comme une sail-lance ou comme un support au travail actif de l’attention créatrice ? Ce n’est pas l’écran comme tel qui fait problème, c’est ce qui y est proposé comme écologie de l’attention, comme situations et comme qualités attentionnelles.

RN : Repartons de l’idée très générale que l’être humain occidental de 2016 est tout

le temps pris entre ses limites

et sa volonté de les dépasser, entre son souci et sa crainte

de l’autonomie. Les promesses d’autoaccomplissement des individus et d’autoconstruction de la société sont des principes actifs des réalités de notre modernité. Au vu de tout cela, ces idées de subjectivation computationnelle, de surcharge par sollicitation et de commen-surabilité de tous les types d’attention relèvent-elles toujours de cette modernité-là ? Ou sommes-nous en train

de passer dans un autre régime ?

YC : Katherine Hayles est une chercheuse américaine qui a très bien décrit les ambivalences de la place des médias dans nos régimes d’attention. Elle critique ainsi le projet trans-humaniste : pour elle, cette idée de télécharger son cerveau sur un ordinateur

et ensuite le transférer dans un autre corps, jeune, pour devenir immortel, etc., c’est nier la complexité de la con-naissance humaine, qui est une connaissance corporée. Notre attention est embar-quée dans un corps sensible au plaisir, à la douleur, à la beauté. Or ces sensibilités sont filtrantes. L’humain construit à travers elles toutes ses connaissances.

Le corps n’est pas réductible

à une prothèse du cerveau,

il n’en est pas séparable.

C’est avec cette grille de lecture qu’il convient d’examiner

ce que j’appelle l’exoattention, qui peut donner un morceau de réponse sur l’enjeu de l’autonomie. De quoi s’agit-il ? Cela s’ancre dans cette idée que depuis le paléolithique toute l’histoire de l’humanité peut être comprise comme l’histoire d’habiletés qui étaient d’abord corporées, mais que les humains arrivent à extérioriser sous la forme d’outils. Qu’est-ce qu’un silex ? C’est un ongle plus puissant.

On extériorise la mémoire à travers l’écriture, la capacité d’entendre à travers l’enregistrement par gramophone, etc. Jusqu’à présent et pour simplifier, on extériorisait des enregistrements bruts de tout filtrage : le micro ne sélectionne pas, parmi tout ce qui se passe, ce qui est pertinent ou pas.Votre écoute maintenant, elle, sélectionne ce que je dis et ne fait pas attention au bruit de fond, alors qu’un micro enregistrerait au même niveau ce bruit et nos voix. L’attention est restée le propre de l’humain.

Mais depuis cinq ans, on crée des algorithmes qui pratiquent l’apprentissage profond, le deep learning. Il s’agit de fournir plein de données à une machine — avec les big data c’est facile, on en récupère partout — et ces algorithmes font émerger, non pas la signification, mais des corrélations. À partir d’un certain point, ces corrélations émergent

« toutes seules », sans que les humains aient besoin de dire à la machine à quoi faire attention. Or le travail de l’atten-tion, c’est exactement cela, vous avez un champ de données sensibles, de stimulus, vous les traitez avec plusieurs filtres différents, ce qui génère des figures qui s’extraient d’un fond. Jusqu’à présent seuls les humains pouvaient le faire. Depuis moins d’une dizaine d’années, grâce à la combinai-son d’algorithmes, des big data, d’énormes puissances

de calcul et des gens intelligents qui arrivent à concevoir

et utiliser cela, Amazon, Google, la NSA, etc., fonctionnent tous à cela. L’exoattention a donc extrait de nous, de nos corps, de nos subjectivités, cette aptitude à distinguer les figures d’un fond, soit une partie de l’interface même entre soi et le monde qu’est l’attention.

C’est de nouveau quelque chose d’ambivalent. Soit c’est la fin de l’humain parce que ce qui fait son essence, c’est juste-ment de rendre certaines choses pertinentes ou pas. Nous serions alors en train de basculer dans le transhumain

ou dans le posthumain. Soit l’extériorisation nous laisse toujours dans une position autonome, à la fois en amont parce que c’est nous qui fabriquons ces algorithmes, ces données, ces ingénieurs et ces industries, et également

en aval, où il y a de l’humain qui interprète tout cela, qui

y donne sens. Personne ne me force à acheter ce qu’Amazon a décrété être bon pour moi.

Cela deviendrait vraiment dangereux là où justement je ne pourrais plus choisir parmi les sollicitations que m’envoie Amazon, là où je serais forcé de brancher mes yeux ou mes oreilles sur certaines figures. Il y a un épisode2 d’une série de la BBC Black Mirror, où, dans un monde dystopique, les habitants n’ont plus le choix de se débrancher d’images violentes, de publicité, de sexe, etc. Pour pouvoir choisir

ce qu’ils voient, ils doivent payer. Cela illustre à merveille

un danger potentiel de cette nouvelle exoattention.

À l’inverse, il me semble que nous avons vraiment besoin

de l’exoattention, par exemple pour savoir quelles sont les conséquences environnementales de nos actions, lorsque

je règle mon thermostat, lorsque j’achète tel type de pommes venant du Chili, etc. L’exoattention, cela peut me donner accès à des plans de réalité que je n’ai pas les moyens d’appréhender, moi tout seul et tout petit, des analyses qui se calculent sans que je le sache et qui dépassent complè-tement la conscience personnelle. On peut tout à fait le faire aujourd’hui. Avec une application comme BuYCott, vous pouvez savoir en scannant le code-barre d’un produit s’il

a été produit dans des conditions sociales ou environnemen-tales éhontées. Oui, l’exoattention impliquera la prise

de données, du contrôle, mais si cela nous rend les trans-formations climatiques moins calamiteuses, pourquoi pas ?

RN : Et avec une complexité particulière. Si l’on reprend l’exemple du silex, vous et moi on peut — cela va peut-être prendre du temps — apprendre à en fabriquer un, taillé comme il faut, etc. Alors que programmer des algorithmes…

YC : Ce n’est pas cela qui me préoccupe. Programmer des algorithmes, maintenant, il se trouve des ressources pour l’apprendre ou pour payer les gens qui savent le faire. Je ne désespère pas que l’on puisse s’éduquer les uns les autres pour que l’on soit tous un peu hacker en amateur, c’est même un des impératifs de l’éducation du XXIe siècle.

Ce qui me préoccupe, c’est que l’exoattention s’appuie sur des objets technologiques comme des circuits intégrés. Les produire, non seulement je ne sais pas comment

on fait, mais nous sommes incapables de le faire dans des conditions conviviales, non industrielles, non aliénantes : cela ne peut en effet se pro-duire que dans d’immenses usines, des installations com-plètement aseptisées, qui mobilisent des millions d’euros de capital fixe. Quelque chose comme un téléphone portable, il y a dedans tellement de degrés

YC : Ce n’est pas cela qui me préoccupe. Programmer des algorithmes, maintenant, il se trouve des ressources pour l’apprendre ou pour payer les gens qui savent le faire. Je ne désespère pas que l’on puisse s’éduquer les uns les autres pour que l’on soit tous un peu hacker en amateur, c’est même un des impératifs de l’éducation du XXIe siècle.

Ce qui me préoccupe, c’est que l’exoattention s’appuie sur des objets technologiques comme des circuits intégrés. Les produire, non seulement je ne sais pas comment

on fait, mais nous sommes incapables de le faire dans des conditions conviviales, non industrielles, non aliénantes : cela ne peut en effet se pro-duire que dans d’immenses usines, des installations com-plètement aseptisées, qui mobilisent des millions d’euros de capital fixe. Quelque chose comme un téléphone portable, il y a dedans tellement de degrés

d’hétéronomie ! La micro-électronique, le code, la pro-priété intellectuelle, les imbrications entre les différentes applications… C’est sûr que ce n’est pas

du silex ! Donc qu’est-ce que l’on en fait ? Est-ce qu’il faut les condamner parce qu’il n’y a moyen de les produire que de façon hétéronome ? Et aller vivre avec des low tech ? Cela ne me semble pas ridicule, et je respecte les gens qui font ce choix-là, ils ont compris de façon assez forte quelque chose que l’on suspecte et ils agissent

en conséquence. Nous avons cependant en commun

le nucléaire, les pesticides,

la fin de la biodiversité, tous ces risques et transformations globaux dont personne ne peut s’abriter, même dans une retraite rurale. Or le numé-rique est un moyen incon-tournable pour essayer de rendre tout cela habitable malgré tout.

Le défi est de réussir à faire

le pont entre l’un et l’autre,

à la fois développer des ancrages locaux d’autonomie et se brancher sur des réseaux planétaires qui passent par l’électricité, les apps, les Gafam, etc. Il me semble que

d’hétéronomie ! La micro-électronique, le code, la pro-priété intellectuelle, les imbrications entre les différentes applications… C’est sûr que ce n’est pas

du silex ! Donc qu’est-ce que l’on en fait ? Est-ce qu’il faut les condamner parce qu’il n’y a moyen de les produire que de façon hétéronome ? Et aller vivre avec des low tech ? Cela ne me semble pas ridicule, et je respecte les gens qui font ce choix-là, ils ont compris de façon assez forte quelque chose que l’on suspecte et ils agissent

en conséquence. Nous avons cependant en commun

le nucléaire, les pesticides,

la fin de la biodiversité, tous ces risques et transformations globaux dont personne ne peut s’abriter, même dans une retraite rurale. Or le numé-rique est un moyen incon-tournable pour essayer de rendre tout cela habitable malgré tout.

Le défi est de réussir à faire

le pont entre l’un et l’autre,

à la fois développer des ancrages locaux d’autonomie et se brancher sur des réseaux planétaires qui passent par l’électricité, les apps, les Gafam, etc. Il me semble que

c’est dans ce grand écart que doit se penser le politique aujourd’hui.

1 | Voir l’article de Thomas Lemaigre dans La Revue Nouvelle 2016/8 (N° 8).

2 | « Fifteen Million Merits », épisode 2 de la saison 1, 2011.

c’est dans ce grand écart que doit se penser le politique aujourd’hui.

Les métiers du numérique apparaissent aujourd’hui comme des territoires marqués

au masculin dans la plupart des pays

occidentaux (Ashcraft et al., 2016),

avec une sousreprésentation accrue des femmes (European Commission, 2018),

alors que ce n’est qu’à partir des années 1980

que l’espace du numérique s’est reconfiguré

en excluant matériellement ou symboliquement

les femmes des métiers du logiciel (Abbate, 2012 ; Hicks, 2017).

De nombreuses initiatives institutionnelles

ont été lancées pour inverser la tendance,

tel le projet européen WICT (2004) qui a émis des recommandations concernant la formation,

le marché du travail et les entreprises.

Le projet SIGIS (Strategies of Inclusion : Gender and the Information Society)

a recensé plusieurs dizaines d’initiatives

en Europe qui témoignent d’une participation

de femmes dans le numérique, afin d’inspirer

des politiques d’attraction et d’inclusion

des femmes. Son rapport final (SIGIS, 2004, pp. 42-43) identifie trois façons d’apporter

aux femmes l’empowerment nécessaire pour leur inclusion dans les technologies de l’information (TI) : insertion dans des communautés

et des réseaux, mise en visibilité

des professionnelles des TI, et formation.

Nous voulons ici cibler plus particulièrement l’empowerment par les technologies.

De nombreux travaux sur la relation entre

technologie et genre ont posé la question

en termes de pouvoir, souvent pour analyser

la technologie comme moyen, lieux et pratiques

de domination (matérielle ou symbolique),

mais aussi pour défendre l’idée qu’elle peut être

outil de résistance et d’empowerment (par exemple : Wajcman, 2004 ;Faulkner, 2001 ;Plant, 1996 ; Omrod, 1995 ; Haraway, 1990).

L’objectif de l’article est d’étudier différentes pratiques

de maîtrise et de mobilisation des technologies numériques,

qui ont été mises en œuvre par des femmes afin d’augmenter

leur pouvoir et celui d’autres femmes dans le numérique.

Nous avons privilégié des pratiques non mixtes, car les deux facettes de la non-mixité — se protéger et se construire (Lewis et al., 2015) — ont un impact possible

sur l’empowerment. L’empowerment est défini comme

« un processus par lequel des individus développent leur capacité d’agir et d’acquérir un pouvoir » (Biewener, Bacqué, 2015, p. 69). Pour comprendre l’apport des TIC (Technologies de l’information et de la communication),

nous nous sommes appuyées sur le cadre théorique

de la typologie des formes de pouvoir, souvent utilisée

par les auteur.es féministes (Guétat-Bernard, Lapeyre, 2017, p. 10 ; Biewener, Bacqué, 2015, p. 80) : pouvoir avec, pouvoir pour, pouvoir intérieur, pouvoir sur, et nous avons choisi des cas satisfaisant aux critères suivants :

a) des initiatives spontanées ;

b) par des femmes engagées dans les technologies numériques ;

c) dans le but de développer leur pouvoir et celui d’autres femmes par le numérique ;

d) depuis le moment où la participation des femmes

a commencé à décliner.

Notre étude n’a pas vocation à dresser un panorama exhaustif : elle repose sur un échantillon ayant une représentativité théorique (Miles et Huberman, 2003, p. 62), c’est-à-dire visant à comprendre des phénomènes émergents, au cours desquels des femmes en situation de minorité non dominante dans le domaine des technologies numériques, ont pu se saisir de ces technologies pour augmenter leur pouvoir et celui d’autres femmes.

Nos cas sont donc illustratifs des différents types de pouvoir. Ils témoignent tous d’une capacité d’action des initiatrices

qui, pour s’opposer à une situation de domination

ou de discrimination liée à l’exercice d’un pouvoir

sur, ont développé d’autres formes de pouvoir. Le premier,

celui du pouvoir avec, repose sur la force du collectif :

nous montrons comment certains réseaux de femmes,

à différents niveaux et avec différents objectifs, augmentent leur capacité à entrer et/ou à agir dans le numérique.

Le second type correspond au pouvoir pour : nous donnons

à voir comment certaines femmes ont investi un champ d’application technologique leur permettant d’augmenter

la maîtrise de leur corps. Le troisième type, celui du pouvoir intérieur, renvoie au développement de la confiance

en soi et au dépassement d’une domination intériorisée (Calvès, 2009, p. 739) : nous l’illustrons avec les artistes

de la première vague du cyberféminisme.

La notion de pouvoir avec est liée

à la capacité de s’organiser pour défendre un objectif commun.

Il existe une variété de situations

où des femmes se saisissent

des technologies numériques

pour se rassembler et s’entraider,

dans un contexte où la domination masculine ne leur laisse

que peu de place. Il s’agit

de création de réseaux, le plus souvent informels, sans structure hiérarchique. Nous présentons trois types de cas : la collaboration entre expertes informatiques ; le soutien pour progresser vers des positions de pouvoir ; l’incitation à dépasser la barrière de la masculinité

des TIC.

Anita Borg, chercheure connue pour ses contributions

aux systèmes d’exploitation tolérants aux pannes, a lancé

en 1987 aux États-Unis le premier réseau d’expertes

en informatique. Cette communauté en ligne a commencé

à fonctionner grâce à une messagerie expérimentale que Borg était en train de développer, et elle appela cette communauté Systers. L’objectif était de partager de l’information

et des conseils sur les systèmes d’exploitation, ce qui offrait

aux chercheures une alternative au mentorat auquel

elles avaient peu accès, et une plate-forme d’échanges accueillante sur laquelle elles ne risquaient ni insultes,

ni harcèlement, ce qui était une pratique fréquente

dans les forums d’informaticiens. En dix ans le nombre

de participantes est passé de 20 à 2 500. Le réseau en compte aujourd’hui 7 500 et s’inscrit dans une communauté plus large, celle de l’Institut AnitaB.org. Cette initiative a ouvert

la voie à la mise en relation numérique d’expertes dans d’autres domaines (histoire, économie, physique, théologie…) (Regan Shade, 1994).

D’autres réseaux autour de l’expertise informatique

ont vu le jour, notamment en lien avec le mouvement

du logiciel libre, où la communauté des développeurs

se montrait particulièrement hostile aux femmes assimilées

à ce que rejetaient les activistes du libre (F/LOSS, 2006). Par exemple Debian Women (autour du système d’exploitation Debian) ou LinuxChix (autour du système d’exploitation Linux).

L’objectif de cette deuxième catégorie de réseaux

est d’augmenter le nombre de femmes aux postes de pouvoir dans les TIC, particulièrement sujets au plafond de verre.

En 1989, une entrepreneuse dans le numérique Carolyn Leighton a constitué un réseau de femmes travaillant

dans les TIC - Women in Technology International (WITI),

qui s’est ensuite élargi aux femmes technophiles

pour leur offrir des opportunités de formation (webinaire),

de mentorat ou d’emplois, ainsi qu’aux entreprises en quête

d’une diversité accrue dans les postes techniques.

Ce réseau, qui depuis 2001, s’appelle WITI Professional Association, se présente comme le réseau le plus important

(167 000 adhérent.es), et rassemble des individus

(97 % femmes) avec un haut niveau de formation,

et utilisant ou mettant en œuvre des technologies

dans leur vie professionnelle. Le réseau favorise

leur progression professionnelle.

Dans le même esprit, le réseau Women who Code créé en 2011 par trois femmes alliant compétences en marketing digital

et en développement informatique, a pour but ultime

une représentation proportionnelle de femmes à tous niveaux dans le secteur du numérique. À la différence de WITI,

ses membres sont toutes en poste dans le numérique (plus 75 % dans des postes techniques, et 15 % dans des postes d’encadrement ou de direction). Le réseau leur propose

des moyens d’évoluer, ainsi que des opportunités d’emploi,

de visibilité et de participation à des conférences dans les TI.

Cette troisième catégorie de réseaux cherche à attirer des filles et femmes dans le secteur du numérique en les rendant

plus visibles et en leur apportant un soutien, notamment

en proposant des formations en ligne sous différentes formes. Nos exemples traduisent une diversité de cibles. Le réseau Girls in Tech (GIT) a été fondé aux États-Unis en 2007

par une femme ayant d’abord fait carrière dans le marketing

– Adriana Gascoigne – et qui en est toujours présidente,

pour inciter les femmes à entrer dans les TIC, en particulier dans les industries des TI et les start-up numériques. Ce réseau revendique plus de 100 000 membres, avec des chapitres dans 36 pays et des actions propres au contexte de chaque pays. L’objectif majeur est de développer la confiance en soi par des conférences et des formations en ligne (développement de sites Web, infographie…), mais aussi des rassemblements en face

à face (ateliers pratiques, concours …) qui permettent

de rencontrer des professionnelles, ainsi que des hackathons mixtes menés dans un esprit d’égalité.

De façon plus ciblée, le réseau Duchess, fondé en 2007

aux Pays-Bas par l’informaticienne Clara Ko, rassemble

des informaticiennes travaillant sur les technologies Java (langage datant de 1995). Il compte 550 membres, dans 60 pays, et vise à valoriser et promouvoir les femmes travaillant dans le monde Java. Le réseau français, Duchess France,

a été créé en 2010 pour donner aux femmes plus de visibilité dans la communauté Java, et faire connaître ces métiers techniques afin de susciter de nouvelles vocations.

C’est une communauté de techniciennes passionné.es,

qui partagent des connaissances, et poussent les chercheures

à augmenter leur participation dans les conférences avec

un accompagnement très pragmatique (ateliers de préparation à l’écriture de communications, sessions de coaching pour répéter les présentations). Il est dirigé par une équipe

de 11 femmes, toutes spécialistes du langage Java.

La diversité ethnique dans les métiers du numérique

est particulièrement faible aux États-Unis. Cela explique

le lancement en 2011 de Black Girls Code (BGC)

par une ingénieure ayant travaillé plus de vingt ans dans

les biotechnologies, Kimberly Bryant. Son action consiste

à former des filles, et à combler la fracture numérique

qui pénalise particulièrement celles qui se trouvent dans

un milieu défavorisé. L’objectif annoncé est de former 1 million

de filles d’ici à 2040 ! Notre dernier exemple est Lesbian

who tech qui répond à l’invisibilisation des lesbiennes

et des queers dans les métiers du numérique, invisibilisation

qui se retrouve aussi dans les études féministes sur la relation entre genre et technologie (Landström, 2007).

Fondé en 2012 par Leanne Pittsford pour augmenter

la diversité de genre dans le secteur du numérique, ce réseau

a ouvert trois ans plus tard une antenne en France. Son objectif

est d’offrir l’appui du groupe pour prendre confiance et sortir de l’invisibilité dans le milieu professionnel.

Le réseau rassemble aujourd’hui des femmes

qui se reconnaissent comme lesbiennes ou non-binaires,

et revendique plus de 50 000 membres.

La notion de pouvoir pour est liée à l’exercice

de la capacité d’action pour des développements tournés vers l’émancipation. On peut observer

un empowerment de ce type dans l’émergence, sous l’impulsion de femmes, de produits/services visant euxmêmes l’empowerment

des utilisatrices. Le contexte dans lequel

ces activités sont menées est celui de biais discriminants (sexe, ethnie) pouvant accompagner certains développements

en Intelligence Artificielle, notamment

lors de l’utilisation de données massives (big data) pour différentes applications : reconnaissance

des formes et modèles de décision, morphologie genrée des robots et des assistants virtuels (boyd, Crawford, 2012). Ces initiatives montrent une prise en main, souvent

par des femmes, de problèmes jusque-là ignorés. Avant de présenter un cas d’empowerment

des femmes par la mobilisation de technologies numériques récentes, nous allons voir comment des logiques de genre peuvent influencer

la production de ces technologies.

Le caractère mécanique des raisonnements logiques associés aux algorithmes leur a souvent conféré un caractère d’objectivité. Cette propriété est aujourd’hui largement discutée (Cardon, 2015), et différents évènements ont attiré l’attention du public, comme le processus de recrutement interne d’Amazon qui, assisté par un algorithme d’intelligence artificielle (IA), s’est révélé faire preuve de discrimination sexiste à l’embauche. Dans le domaine de l’IA, les résultats produits par les programmes qui transcrivent en machine

les méthodes abstraites que sont les algorithmes, dépendent

de nombreux facteurs dont les variables que manipulent

les algorithmes, l’écriture des programmes, et les données fournies en entrée. Certaines procédures permettent aujourd’hui, dans certains cas, de sélectionner

« automatiquement » des variables « pertinentes », mais l’écriture de ces procédures reposent sur une activité humaine. De plus, l’écriture des programmes relève avant tout

de l’expertise technique et de l’expérimentation. Et, comme

le souligne Schmitt (2016) « la croyance dans l’existence

de données ‘brutes’, non biaisées, non manipulées, qui seraient l’exact reflet des faits qu’elles représentent et parleraient

d’elles-mêmes (…) traduit une conception aujourd’hui largement reconnue comme illusoire » (p. 87).

L’humain reste donc au cœur du processus de conception

et les technologies numériques n’échappent pas aux influences du monde social, et donc aux relations de genre. La logique

de genre peut intervenir à différentes étapes de la conception, intentionnellement ou non. On peut distinguer quatre situations, qui peuvent parfois se combiner dans certaines applications opérationnelles : la reproduction intentionnelle

de stéréotypes de genre ; la production de biais genrés ;

la validation expérimentale des technologies

sur des échantillons biaisés d’usagers ; et l’invisibilité

des enjeux d’égalité dans des logiciels de décision.

Nous illustrons ci-dessous ces quatre situations.

Pour certains usages ciblés, les stéréotypes de genre sont volontairement reproduits. C’est notamment le cas pour

les assistant.es virtuel.les et les robot.es. Laura, Julie Desk

et Sophia sont des noms choisis pour les assistants vocaux

et les robots qui accompagnent désormais les usagers

de services, les salariés d’entreprises, et les expérimentations

en IA. Ainsi, la robote Sophia cumule différents attributs sexués à la fois dans son design avec une apparence très féminisée et dans la communication autour de sa présentation :

« Hi, I am Sophia (…) Think of me as a personification

of our dreams for the future of AI (…) ». De plus, la voix

de ces agents conversationnels active des stéréotypes.

La version américaine de Siri a « la voix d’une adolescente,

une qualité de voix un peu mignonne, sentimentale, qui évoque

celle d’une jeune femme que l’on pourrait aimer »

(Cassel, 2018).

La deuxième situation est l’introduction de biais de genre,

non explicitement intentionnelle, par des algorithmes d’intelligence artificielle qui apprennent à partir

des bases de données biaisées. Un des facteurs majeurs

de l’efficacité croissante des logiciels d’apprentissage automatique repose sur la taille et la qualité des bases

de données qui servent à les entraîner. Or des recherches récentes mettent en évidence le caractère genré de certaines bases et des résultats biaisés qu’elles engendrent. Par exemple, une étude récente de trois logiciels majeurs reconnaissance faciale –basés sur une typologie binaire classiquement utilisée dans ce domaine– a montré qu’ils avaient tous de meilleures performances sur les visages d’hommes (Buolamwini

et Gebru, 2018).

En traitement automatique de la langue, les approches les plus populaires de représentation des termes encodent

des associations sexistes, telles que « man is to computer programmer as woman is to homemaker » (Bolukbasi et al, 2016). Ces associations sexistes explicites peuvent s’associer

à une non neutralité plus cachée. Dans Wikipédia, largement utilisé en ingénierie des connaissances, les articles consacrés

à des femmes soulignent souvent leurs statuts de femmes

en précisant leurs maris, leurs enfants, et leurs parcours singuliers en tant que femmes (Wagner et al. 2016).

De plus, Wikipédia concentre les inégalités femmes-hommes avec une invisibilité des femmes puisque moins de 20 %

des 30 millions de fiches sont consacrées à des femmes.

Si une part de l’informatique reste théorique et la rapproche des mathématiques, une part croissante est devenue expérimentale. La validation des artefacts produits est alors soumise aux questionnements de protocoles expérimentaux. Lorsque ces derniers incluent des utilisateur.es l’existence

de biais genrés devient une hypothèse légitime à tester.

À notre connaissance, en informatique, aucune étude à large échelle n’a analysé sous l’angle du genre la composition

des échantillons de tests. Or, comme ceux-ci sont souvent menés dans les environnements de développement où la sur-représentation masculine est attestée, la probabilité de biais

est assez forte. Le témoignage de la directrice du laboratoire Facebook AI Research de Montréal sur une expérience

d’un de ses stages de jeunesse portant sur un système

de reconnaissance vocale dans les cockpits d’hélicoptères

est une illustration paradigmatique : « Le système était

en place, nous étions en train de le tester (…). Tout à coup, l’équipe se rend compte que tous les sujets de l’étude

sont des hommes. Je me retrouve donc aux commandes

d’un hélicoptère, dans le rôle du sujet féminin. ».

Le premier workshop autour des questions de genre

dans la principale conférence internationale d’interaction

homme-machine (CHI) confirme que souvent le genre

n’est pas un facteur explicitement considéré dans le design

des technologies interactives et lorsqu’il l’est les produits sont élaborés à partir de modèles idéalisés (Thomas et Mavin, 2014). Dans le domaine de l’aide à la décision, les enjeux d’égalité sont très peu présents et certaines n’hésitent

pas à affirmer que « the features of commercial software tools are usually optimized around the preferences of male developers » (Williams, 2014).

Dans ce contexte de l’innovation numérique, peu féminisé

et peu marqué par des préoccupations de genre, certaines femmes se sont positionnées sur des niches encore

peu explorées manifestant ainsi une capacité d’action

et favorisant un empowerment accru pour d’autres femmes.

L’exemple le plus notable est celui des technologies de suivi

de données corporelles spécifiques aux femmes.

Les applications qui s’inscrivent dans le mouvement

du « quantified self » ont été lancées en 2008 et visent

à recueillir des données corporelles personnelles (tension, calories consommées, sommeil, nombre de pas…) à des fins d’analyse. Elles ont connu un essor considérable,

avec des objectifs de santé ou de bien-être. Cependant,

les innovateurs du numérique ont largement ignoré

les usages féminins spécifiques. Ainsi, l’outil santé d’Apple

et la plateforme HealthKit n’ont intégré un suivi de la santé reproductive qu’au bout d’un an, en 2015, sous la pression

des utilisatrices, et un des principaux outils du marché, Fitbit, n’a ajouté une fonction de suivi menstruel qu’en 2018.

Pourtant, dès 2009, une jeune entrepreneuse danoise, Ida Tin, cherchant un moyen de suivre son cycle menstruel

et ses périodes de fertilité, a conçu et fait développer

une application de suivi des cycles qui a conduit en 2012

à l’application allemande Clue. Tin a voulu une interface d’apparence neutre (couleur, tonalité, images…) en phase avec des contenus scientifiquement fondés. Cette application gratuite qui revendique 2,5 millions d’utilisatrices dans

180 pays, a été présentée dans la presse comme « The health

app that hopes to empower women » (BBC News, 20153 ).

Quelques années après, devant l’engouement des utilisatrices, les applications se sont multipliées (Myamoto et Pau, 2018), notamment aux États-Unis (Glow, Period tracker Lite…) et au Japon (Luna Luna, Selene Calendar…). Aujourd’hui, ces applications sont souvent référencées

par le terme « Femtech », qui a été forgé à la fin des années 2000 par Ida Tin. Elles apportent aussi des informations, conseils, moyens d’échanges sur la santé spécifique des femmes (cycles menstruels, fécondation, grossesse, contraception, syndrome prémenstruel, sexualité…). Elles augmentent

la capacité de décision et l’autonomie des utilisatrices,

par une connaissance accrue du fonctionnement de leurs corps

et de la reproduction, et une maîtrise de leurs données personnelles. Ces thèmes, qui semblaient tabous dans le monde de l’innovation numérique, ont été initialement portés

par des femmes, et ensuite investis plus largement compte tenu des enjeux financiers.

En France, la première conférence sur « L’état de l’art

de la menstrutech » s’est déroulée en 2018 dans le cadre

du festival Futur.e.s . Des plateformes pour soutenir le secteur

de la Femtech, en particulier les entrepreneuses, ont vu le jour (France Femtech, Eve Femtech Hub…) pour inciter

à des innovations technologiques permettant aux femmes

de s’impliquer dans une maîtrise accrue de leur santé reproductive. Les applications sur téléphone mobile dédiées

à la santé des femmes nourrissent de grands espoirs pour l’empowerment des femmes (autonomie, responsabilisation) dans les pays en voie de développement.

Cependant, une recherche sur le projet Motech (Mobile Technology for Community Health) 5 pour le suivi

de grossesse au Ghana et en Inde montre que les conditions dans lesquelles l’utilisation de l’outil a été pensée et organisée

n’a guère augmenté la capacité d’action de ces femmes

(Al Dahdah, 2017). En effet, l’outil a, le plus souvent,

été imposé à un échantillon de femmes sans qu’elles aient donné leur accord ; en Inde, les femmes ont découvert

a posteriori que son utilisation n’était pas gratuite ;

les brefs messages vocaux hebdomadaires qui leur dictaient

le comportement à adopter, ont souvent été perçus comme

des injonctions peu fondées car contraires à leur propre expérience et savoir local ; le système ne permettait aucun dialogue avec les émetteurs de ces messages ; certains ordres étaient inconciliables avec leur propre calendrier (aller à une consultation le jour de marché) ou leur état à ce moment-là (absence de lactation) ou les moyens disponibles (absence

de transport le jour de l’accouchement). Au lieu d’augmenter

la capacité d’action, ce système était au contraire un facteur d’aliénation. Le processus d’empowerment est soumis

à une condition majeure : une utilisation volontaire

par des femmes qui intègrent le dispositif dans leur

vie au quotidien, non par des prescriptions à respecter,

mais par des informations pouvant avoir un sens. Cela renvoie à la conception de l’outil, fondée sur un modèle abstrait

et une vision simplifiée des problèmes de santé dans les pays

en développement (ignorance des femmes), sans adaptation aux conditions locales.

Le pouvoir intérieur correspond à une dimension subjective de l’empowerment : c’est la prise

de conscience de soi comme un être pleinement humain et peut-être le développement

d’une identité renouvelée. Pour illustrer

ce troisième type d’empowerment, nous avons retenu le cas de la première vague

du cyberféminisme, et plus particulièrement celui du premier groupe artistique qui s’est revendiqué comme cyberféministe. En 1991, quatre artistes australiennes prennent le nom de VSN Matrix, VSN pouvant être lu comme Vénus ou comme

un acronyme connotant le monde des affaires,

et la matrice jouant sur l’ambiguïté entre utérus

et matrice numérique. Ce groupe publie

un Manifeste cyberféministe pour le 21e siècle sous forme d’une image digitale représentant

une sphère avec un texte provocateur,

qui se répandit de façon virale sur les listes

de diffusion féministes et fut traduit

en plusieurs langues.

Les artistes ont été inspirées

par le Manifeste cyborg (Haraway, 1990) qui propose une vision de l’identité

et des rapports entre humain.es, renouvelée par les possibilités d’hybridation entre vivants

et artefacts. Sans développer

les formes variées prises

par le cyberféministe dans

les années 1990 (Paasonen, 2011), nous voulons pointer

sur le collectif VSN Matrix

dans la mesure où la première vague du cyberféminisme

fut très souvent associée

aux créations numériques.

Ces artistes se sont saisies des technologies numériques avec l’utopie qu’elles pourraient « create new languages, programs, platforms, images, fluid identities and multi-subject definitions in cyberspace » (Fernandez et Wilding, 2002, p. 21).

Au-delà du plaisir de jouer avec la technologie, elles cherchent

à développer leur capacité d’action et à affirmer une identité

qui ne soit pas définie par rapport à un modèle masculin toujours posé comme l’original et l’idéal (Wajcman, 2004,

p. 63). On peut donc voir dans cette affirmation émergente

du cyberféminisme le développement d’un pouvoir intérieur, nourri par la diffusion électronique du « virus du féminisme » (Plant, 1996), mais aussi par l’appropriation technique (Couey, 2003). VSN Matrix a notamment développé

un jeu vidéo qui s’appuie sur la métaphore du hacker,

mais de façon subversive : l’objectif du jeu est de pénétrer

dans les banques de données de l’ennemi principal (Big Daddy),

mais pour les altérer et non pas pour en prendre le contrôle (Sofia, 2003).

La mise en place de réseaux a répondu

à des contextes où l’on trouvait pratiques d’exclusion, plafond de verre, image masculine des TIC, fracture digitale entre hommes

et femmes, et marginalisation des femmes.

Margré la diversité de leurs origines et de leurs terrains de déploiement, ces réseaux présentent plusieurs caractéristiques communes.

Ce sont des espaces de ressources : ils offrent

des informations, des connaissances

et des formations. Ce sont des espaces d’aide

et collaboration, soit sur des problèmes

ou projets, soit par des accompagnements

dans le parcours professionnel.

Ce sont aussi des espaces de renforcement personnel,

par la mise en visibilité de soi devant d’autres

et par les retours positifs qu’on en reçoit. Ce sont enfin

des espaces de construction d’une identité collective positive.

Ces réseaux montrent la capacité de s’organiser pour agir

à la fois sur la dimension individuelle de l’empowerment

(développement des capacités personnelles, efficacité personnelle accrue) et sur sa dimension collective

(conquériret défendre une place pour les femmes

dans le monde professionnel du numérique).

Ils suggèrent que l’empowerment requiert des espaces

collectifs de construction d’une identité

empowered. La dimension mono-sexuée de ces réseaux

de femmes permet d’échapper aux normes d’interaction

socio-sexuées et aux pratiques de domination de genre.

C’est aussi l’assurance de pouvoir développer autonomie

et confiance en soi. Le cas de la femtech témoigne d’un déficit

de pensée du genre dans le développement informatique

qui peut se révéler une source d’opportunités :

c’est en se glissant dans les interstices qui, invisibles au départ, ne sont pas un enjeu de pouvoir, que des femmes

ont pu innover.

La possibilité pour des artistes de subvertir le cyberespace

est le signe de l’émergence d’une conscience critique qui conduit

à renverser les effets aliénants de la technologie.

Les illustrations que nous avons données font apparaître

deux dimensions du pouvoir décrites par (Guérin, 2017).

La première est celle de la matérialité du pouvoir. Les processus d’empowerment (pouvoir avec, pouvoir pour, pouvoir intérieur) n’auraient pu émerger si les femmes initiatrices n’avaient

eu l’accès et la maîtrise technologique nécessaires

pour construire des alternatives (réseau, site, logiciel…).

Cette dimension matérielle du pouvoir montre l’importance

d’une plus grande mixité dans les métiers du numérique,

que ce soit dans le développement, la recherche

ou l’entreprenariat.

La deuxième dimension est celle de l’affect.

Alors que les sentiments négatifs (mépris, humiliation, invisibilité…) entravent la capacité d’action, les sentiments positifs (amitié, plaisir…) la favorisent. Dans nos cas, on peut relever que le refus d’être marginalisées (difficulté d’accès

à des groupes), ignorées (compétences peu reconnues, attentes ignorées), dépréciées (images négatives) a conduit des femmes à innover et à s’emparer de technologies. Le plaisir de créer,

qui a été dynamisé par des réponses positives (développement d’un réseau, utilisation d’un logiciel…) a été un facteur fort d’empowerment. La création de communautés a suscité

de nouvelles relations favorisant la reconnaissance mutuelle.

Notre étude des trois formes de processus d’empowerment dans le numérique

–porté par un collectif (pouvoir avec),

visant à une autonomie accrue (pouvoir pour), permettant de dépasser une domination intériorisée– montre que les innovations numériques ont très vite été utilisées

par des femmes pour acquérir du pouvoir depuis plus de trente ans. Depuis une dizaine d’années, les technologies du Web 2.0 (blogs, podcasts, réseaux sociaux numériques…) ont été utilisées par de nombreux mouvements féministes,

ce que l’on regroupe sous le terme

« cyberféminisme ». Débordant le contour

de sa première vague, le cyberféminisme (parfois qualifié de « 2.0 ») est aujourd’hui défini comme « une pratique activiste, liée à l’idéologie d’ouverture propre au réseau, visant le partage

de connaissances autant techniques

que théoriques de même que l’accessibilité

des outils de création et de diffusion

pour les femmes et groupes de femmes »

(Lalonde, 2012, p. 9).

Des recherches récentes montrent de jeunes féministes

non professionnelles du numérique, qui ont développé

des compétences techniques leur permettant de ne plus être dépendantes de professionnels extérieurs (Jouët et al., 2017). Cependant au-delà de cette acquisition de compétences d'utilisatrices éclairées, on observe une baisse continue

de professionnelles des TIC (voir par exemple l'initiative

du collectif Femmes@Numérique). Comme nous l'avions analysé dans des travaux précédents, ce phénomène

est directement lié à la persistance d'un stéréotype dévalorisant les femmes par rapport à la technique

( Morley et McDonnell , 2017), qui est source

de discrimination.

Quelle que soit sa forme, l'empowerment des femmes

par les TIC atteint ses limites pour lutter contre

ces discriminations insidieuses. L'analyse des succès locaux d'inclusion d'une mixité durable dans les filières du numérique met en lumière le rôle essentiel d'un changement de culture pour la rendre inclusive ( Morley et Collet , 2017).

La non-acceptation sociale des biais générés

par les applications d'apprentissage automatique et plus généralement des logiciels se manifeste depuis quelques années par des publications aussi bien académiques (par exemple Burnett et al. , 2016) que grand public (par ex. O'Neil , 2016 ; Criado Pérez, 2019). Les cas d'empowerment

par la prise en main de conception technologique

par des femmes sont embryonnaires, mais s'ouvrent

sur un champ de recherche qui questionne sous l'angle

du genre les processus de décision et de conception

de produits/services numériques utilisés au quotidien.

Le présent article est une réponse à un appel fait par la recherche en sémiotique pour caractériser un ensemble de phénomènes (textuels et/ou visuels) ayant fait l’objet d’une attention médiatique particulière ces dernières années, regroupés sous le terme global de fake news. Plus particulièrement, il s’agit ici de faire le point sur les apports d’une perspective théorique et empirique spécifique, à la compréhension de ces phénomènes : celle de la cyberpsychologie, et notamment de la psychologie expérimentale sur laquelle elle s’appuie. Nous aborderons en premier lieu la question des fake news et des connaissances issues de la cyberpsychologie relatives à leur crédibilité. Dans un second temps, nous aborderons une évolution technologique récente : celle des deepfakes, qui posent des questions nouvelles sur les facteurs influençant la crédibilité des fake news, mais aussi sur les stratégies qui permettent de s’en prémunir.

Une fake news est ainsi définie comme un élément médiatique factuellement inexact mais présenté par son émetteur comme ayant une valeur de véracité avec une volonté explicite de tromper le récepteur de ce dernier (Pennycook & Rand, 2021). Si le phénomène est ancien – Kalsnes (2018) donne plusieurs exemples datant de la fin du XIXème siècle visant par exemple à augmenter les chiffres de vente d’un journal, à divertir un public, ou encore à attiser des sentiments d’hostilité à l’égard d’une minorité – ce terme est réapparu au cours des cinq dernières années, à la faveur de deux phénomènes distincts : (1) la survenue de plusieurs évènements démocratiques historiques, par exemple le référendum sur l’appartenance du Royaume-Uni à l’Union Européenne, qui a donné lieu au Brexit, ou encore l’élection de Donald Trump à la présidence des Etats-Unis d’Amérique, qui en a incontestablement popularisé l’usage et (2) l’irruption des réseaux sociaux dans ces évènements, comme vecteurs de ces messages erronés mais susceptibles d’infléchir sur les résultats des votes. L’intérêt de la psychologie pour ce thème émergent est double. En premier lieu, il permet d’explorer des thèmes classiques en psychologie sociale tels que la formation de croyances et ses liens avec la prise de décision, sous un angle nouveau : l’étude de la crédulité et des facteurs individuels et contextuels qui la favorisent (Forgas & Baumeister, 2019). En second lieu, naturellement, l’objectif de telles études est souvent de proposer des pistes pour prévenir de telles tromperies ou d’en atténuer les conséquences.

L’intérêt récent pour les fake news tient à leurs effets supposés sur la prise de décision humaine. En psychologie cognitive, un programme de recherche initié dans les années 1960 et 1970 a contribué à montrer en quoi l’être humain ne pouvait être considéré comme un agent décisionnel parfaitement rationnel

est un type de siège, c'est-à-dire de meuble muni d’un dossier et destiné à ce qu’une personne s’assoit dessus.

(Kahneman et al., 1982). En effet, selon le modèle classique défendu notamment en sciences économiques, lorsque l’être humain est confronté à une situation où (1) il peut choisir entre plusieurs actions possibles et (2) de ce choix découlera une issue plus ou moins avantageuse, alors sa décision reposera sur un calcul intégrant, d’une part, le caractère plus ou moins avantageux de chaque issue et d’autre part, la probabilité que telle décision donnera effectivement lieu à telle issue. Dans une situation simpliste dite de jugement sous certitude, où telle action donnera lieu, dans tous les cas, à une issue donnée, la prise de décision est fondée uniquement sur l’évaluation des bénéfices comparés de chaque issue. En pratique, cependant, le lien entre un choix et une issue n’est pas certain. La qualité de la prise de décision dépendra de celle de l’information sur laquelle elle s’appuie. Cependant, l’être humain dispose de ressources limitées pour la prise de décision, que celles-ci soient internes – c’est à dire cognitives, par exemple attentionnelles ou mnésiques

En biologie ce qui concerne la mémoire, ou des moyens facilitant la conservation des souvenirs.

– ou externes à l’individu, par exemple lorsqu’une décision est prise sous contrainte temporelle. Dans ces situations de prise de décision sous incertitude, l’agent décisionnel ne traite pas toutes les informations dont il dispose, mais juste suffisamment d’informations pour parvenir à une issue satisfaisante (Simon, 1957). Ce faisant, il s’appuie sur des heuristiques,

Partie de l’histoire de la science qui consiste à la recherche des documents. Et discipline qui consiste à formuler les règles de la recherche scientifique.

c’est-à-dire des principes visant à simplifier les traitements d’information impliqués dans le calcul des probabilités de chaque issue et les utilités associées (Tversky & Kahneman, 1974). La notion de biais renvoie au fait que ces jugements subjectifs sont parfois erronés, et ce de manière prévisible.

Une première piste pour comprendre les effets des fake news sur la prise de décision a été mise en évidence par Hasher et al. (1977). Ces auteurs ont exposé leurs participants à quarante affirmations plausibles et leur ont demandé d’en évaluer la vraisemblance. Ils ont répété l’expérience trois fois à deux semaines d’intervalle. D’une session à l’autre, la moitié des affirmations présentées était nouvelle, tandis que les autres étaient répétées d’une fois sur l’autre. Les résultats ont montré que la simple exposition répétée à une affirmation augmentait sa vraisemblance perçue. Cet effet dit de vérité illusoire pourrait expliquer la croyance dans la véracité des fake news, dès lors que celles-ci sont diffusées massivement via les réseaux sociaux et les canaux médiatiques traditionnels.

Deux explications ont été avancées pour expliquer l’effet de vérité illusoire. La première, dite référentielle, repose sur le fait que l’individu est capable de se souvenir qu’il a déjà été exposé à une affirmation. De plus, si l’affirmation était accompagnée d’une information sur sa valeur de vérité – vraie ou fausse – l’individu peut se référer à cette information (Brown & Nix, 1996). La seconde, dite non-référentielle, intervient même lorsque l’individu ne dispose pas d’une information de véracité, et repose sur le fait que la simple exposition répétée à une même affirmation facilite son traitement cognitif ultérieur. Cette facilité de traitement est perçue à son tour comme un indice de la véracité de l’affirmation (Unkelbach & Stahl, 2009). Autrement dit, la simple exposition répétée à une fake news pourrait suffire à rendre celle-ci crédible aux yeux du lecteur.